Изкуственият интелект добави нова измама към фалшивото представяне, разширявайки обхвата му и увеличавайки въздействието върху жертвите

„Фишинг“ (phishing) атаките, които още от 90-те години използваха фалшиви имейли за измама на нищо неподозиращи жертви, еволюираха в измамнически атаки, които използват фалшиви текстови съобщения (smishing). Сега тази еволюция навлезе в нов етап с гласов фишинг – „вишинг“ (vishing) – атаки, които включват клониране на гласа на човек.

Един от методите е да се изпрати гласово съобщение, генерирано от изкуствен интелект (AI), привидно от страна на паникьосано дете или внуче до член на семейството. Съобщението подтиква члена на семейството да изпрати пари, често чрез фалшива банкова връзка.

„Ежедневният вишинг сценарий е телефонно обаждане с високо напрежение за ‘спешен проблем’,“ каза Нейтън Хаус, главен изпълнителен директор на StationX, британска платформа за обучение по киберсигурност, пред The Epoch Times.

„Обаждащият се маскира номера на вашата банка, твърди, че акаунтът ви е компрометиран, и трябва да ‘потвърдите’ еднократен код, който току-що са ви изпратили — всъщност това е вашият истински код за двуфакторна автентикация.

Други варианти имитират полиция, дружества за комунални услуги или паникьосан роднина, всички от които искат спешно средства.

„Отличителните белези са познато име на екрана при входящо обаждане, емоционална или финансова заплаха и искане за незабавно действие — обикновено споделяне на данни за достъп, прочитане на код или превеждане на пари.“

Юргита Лапиените, главен редактор на Cybernews, литовска медийна платформа, фокусирана върху киберсигурността, подчерта нарастващото разпространение на гласовите фишинг атаки.

Тя предупреди, че докато настоящата AI технология за клониране на глас може само да следва предварително написан сценарий и не може да реагира спонтанно на въпроси или отговори в реално време, само въпрос на време е, докато технологията, базирана на изкуствен интелект, наистина се научи да бъде по-подобна на хората и да може да бъде използвана като оръжие срещу тях.

„Ако чувствам, че наистина говоря с мой роднина, ще съм по-склонна да му дам пари назаем, защото съм убедена, че това е действителният човек, с когото говоря, и това е наистина опасно,“ каза тя.

Годишният доклад за киберпрестъпност от Центъра за жалби относно интернет престъпления (IC3) на ФБР, публикуван на 23 април, посочва, че през 2024 г. са получени 193,407 оплаквания за фишинг или фалшиво представяне (техника, при която измамниците маскират собствените си телефонни номера и карат жертвите да мислят, че са адресат на истинско обаждане). Това го прави най-разпространения тип измама, в сравнение с 86,415 оплаквания за изнудване и 441 оплаквания за злонамерен софтуер.

Хаус каза, че докладът на ФБР показва колко разпространен е станал проблемът с фишинга или фалшивото представяне.

„Фишингът, фалшивото представяне и техните производни — гласов фишинг, смишинг, QR фишинг — са били главните изпълнители на киберпрестъпността от години, защото са евтини за реализиране и могат да достигнат до милиони цели почти без технически умения,“ каза той.

Лапиените посочва, че става все по-евтино да се мамят хора с помощта на клониране на глас.

„През 2020 г., ако сте искали да клонирате глас, вероятно са ви били нужни около 20 минути запис,“ каза тя.

„В днешно време, с AI и автоматизацията, и други иновации, ви трябват само няколко секунди от нечий глас, и можете да… направите запис, наподобяващ човека, когото се опитвате да имитирате.“

Хаус каза, че на измамниците са нужни само няколко секунди аудио, като например „клип от TikTok или кратко обаждане на грешен номер“, за да направят убедително копие, използвайки AI инструменти за клониране на глас.

„Това значително понижава бариерата на разходите и уменията,“ каза той. „Престъпниците вече не се нуждаят от студийно качество на звука или дълги записи. Така че те могат да вземат откъси, публикувани онлайн, да ги вкарат в безплатна машина за клониране и да започнат да набират.“

Според IC3, хората над 60-годишна възраст са претърпели загуби от почти 5 милиарда долара от киберпрестъпления през 2024 г. и са подали най-много оплаквания до агенцията.

И би могло да стане много по-зле — Центърът за финансови услуги на Deloitte посочи в доклад, публикуван през май 2024 г., че загубите от AI измами биха могли да достигнат 40 милиарда долара в Съединените щати до 2027 г.

През май 2023 г. Теджей Флетчър, на 35 години, бе осъден на 13 години и четири месеца от съдия в Лондон за ролята си в управлението на iSpoof – уебсайт, който се превърна в „магазин за измами“ за измамници, които са излъгали, за да получат около 43 милиона паунда от жители на Обединеното кралство и голяма, неуточнена сума от жертви в Съединените щати.

Измамниците купували софтуер за фалшиво представяне, като например Interactive Voice Response, от сайта, който е генерирал 112.6 биткойна (1.08 милиона долара) за Флетчър и неговите съучастници.

През 2019 г. The Wall Street Journal съобщи, че измамата гласов фишинг е подмамила изпълнителен директор на британска енергийна фирма да преведе 220,000 евро, след като го е убедила, че говори с шефа си в Германия.

„Обирите чрез гласови дийпфейк остават рядко заглавие в новините, но те почти със сигурност се докладват по-малко, защото компаниите се страхуват от удар по репутацията,“ каза Хаус.

„Само шепа са излезли публично, но загубите от компрометиране на бизнес имейли — в които тези CEO гласови измами се вписват — вече се измерват в милиарди всяка година.

„Възможно е гласовите дийпфейк измами да са източили колективно много милиони.“

Хаус каза, че повечето инциденти са били отписани като измами с банкови преводи.

Лапиените се съгласи, че има недостатъчно докладване на вишинг и други измами — особено сред възрастните хора, които често се срамуват да признаят, че са били измамени „защото се чувстват самотни и не искат да бъдат осмивани.“

Директорът на ФБР Каш Пател каза в изявление от 23 април: „Докладването е една от първите и най-важните стъпки в борбата с престъпността, за да може правоприлагащите органи да използват тази информация за борба с различни измами и схеми.“

„Наложително е обществеността незабавно да докладва на ФБР за подозрителна престъпна дейност, осъществявана чрез киберпространството.“

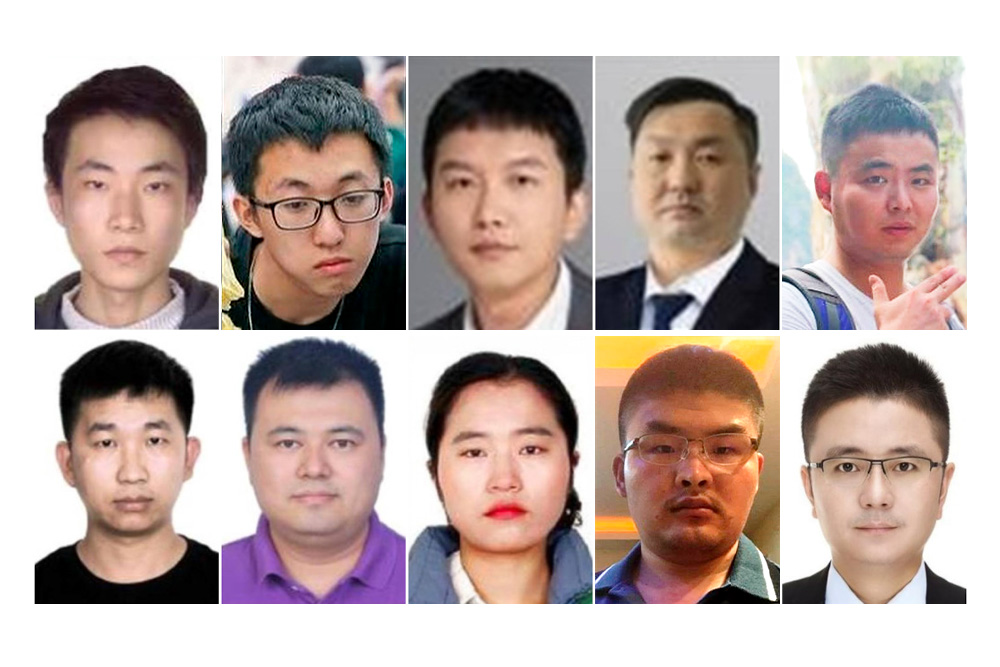

Китайски организирани престъпни синдикати, като триадата 14K, през последните години са изградили големи центрове за киберизмами в Камбоджа, Лаос и Бирма, които са насочени към американци.

Ерин Уест е бивш прокурор, който сега ръководи Operation Shamrock, която се стреми да подчертае заплахата от индустрията за киберизмами. Тя каза, че триадите „трябва да се страхуваме от тях на нивото на всяка злонамерена държава.“

„Те са толкова големи, толкова организирани, толкова добре финансирани,“ каза тя пред The Epoch Times в скорошно интервю.

Лапиение също каза, че югоизточноазиатската индустрия за киберизмами сега е по-вероятно да провежда мащабни фишинг атаки с имитиране на човешки глас, отколкото просто да се насочва към „голямата риба.“

Тя каза, че докато измамниците могат да се насочат към възрастните хора и тези, които живеят сами, целите често се избират на случаен принцип.

„Може да бъде всеки,“ каза Лапиение. „Измамниците също имат любимо време за измама, по време на празниците или сутрин, когато хората са по-отпуснати или не мислят ясно.“

Тя отбеляза, че възрастните хора често са мишена на романтични измамници.

„В тези романтични измами, те изграждат напълно нова персона,“ каза тя. „Така че определено могат да фалшифицират глас, но мисля, че е по-опасно, когато успеят да фалшифицират гласа на някого като роднина, или може би някой в компанията, или някой, когото познавате… Много по-лично е.“

Лапиение каза, че клонирането на глас също представлява опасност за медиите.

На 11 април търговското списание Press Gazette на Обединеното кралство съобщи, че няколко медии, включително Yahoo News, са изтрили статии поради опасения, че така наречените експерти, които са интервюирали, са били генерирани от AI ботове.

„Преди AI да се появи, щяхте да проверите дали човекът е човек,“ каза Лапиение. „Така че щяхте да вдигнете телефона и да им се обадите, просто да поговорите малко, да проверите дали това е човек, с когото говорите.“

Тя каза, че AI сега е в състояние да фалшифицира както видеа, така и гласове, което прави по-трудно да се провери дали интервюираният е истински човек.

Лапиение каза, че докато AI се подобрява всеки ден, в момента софтуерът за клониране на глас не е в състояние да имитира перфектно хората и често звучи роботизирано или лишено от чувство за хумор.

Тя каза, че няма нито паузи, нито грешки на езика, нито незавършени изречения, които хората правят, когато говорят.

„Но те ще стигнат дотам, мисля, по-скоро, отколкото по-късно, и тогава ще бъде наистина страшно,“ каза Лапиение.

Starling Bank, британска дигитална банка, създаде филм в YouTube през септември 2024 г., в който актьорът Джеймс Несбит предупреждава за увеличаването на измамите с клониране на глас.

Във видеото Несбит казва: „Измамите с AI клониране на глас се увеличават и всеки може да стане жертва.“

Несбит, чийто съвет е одобрен от Starling, предлага хората да изберат „безопасна фраза“, като например „семеен вътрешен виц“, и да я използват, за да проверят дали наистина говорят с роднината или приятеля, който мислят, че е от другата страна на телефона.

Хаус посочва, че кодова дума между членовете на семейството „е проста, ефективна спирачка.“

„Ако някой се обади, звучейки като вашия син, който моли за пари за гаранция, [попитайте] за договорената фраза — нещо, което никой външен не би могъл да предположи,“ каза той. „Това принуждава имитатора да излезе от ролята си или да затвори.“

Той каза, че това не е безотказно, но е нискотехнологична защита, която би могла драматично да отслаби измамите с клониране на глас.

Лапиение посочи реалността на повечето обаждания: „Проблемът е, че когато някой близък ви се обажда, вие не се опитвате да проверите самоличността му. Не издигате защитни щитове, ‘Наистина ли ме търси майка ми?’

„И знаете, не искам наистина да живея в такъв свят, в който правим това.“

Хаус каза, че банките и други финансови организации биха могли да направят много повече за справяне с вишинга и фалшивото представяне.

„Банките трябва да изискват потвърждение извън използвания канал — обратно обаждане на известен номер — преди всеки трансфер на голяма сума и никога да не разчитат само на глас,“ каза той.

Той отбеляза, че телефонните компании в Съединените щати трябва да завършат въвеждането на автентикация на идентификацията на обаждащия се като Secure Telephone Identity Revisited и Signature-based Handling of Asserted Information Using toKENs, колективно известни като STIR/SHAKEN.

Той каза, че телекомуникационната индустрия също трябва „агресивно да етикетира или блокира фалшивите номера.“

„Екипите по киберсигурност могат да пуснат персонала през симулации на гласов фишинг, да внедрят AI детекция, която маркира синтетичните гласове, и да поставят изрични предупреждения като ‘Никога няма да искаме код по телефона’ във всяка точка на контакт с клиента,“ каза Хаус.

„Заедно тези мерки повишават разходите за измамниците и добавят съпротивление в критичния момент на вземане на решение.“